Paper Notes 2024

2024-12月

Light Gradient Boosting Machine (LightGBM) 是什么模型

Light Gradient Boosting Machine (LightGBM) 是一种高效的梯度提升树(Gradient Boosting Decision Tree, GBDT)模型。它是由微软 DMTK(Distributed Machine Learning Toolkit)团队开发的,旨在提高传统梯度提升模型的速度和效率。LightGBM 通常用于处理大规模数据集,并且能够在机器学习竞赛中取得优秀的成绩,尤其是在 Kaggle 等平台上。

LightGBM 的基本概念

LightGBM 是一个基于树的算法,属于 提升树(Boosting Trees) 类的一种,它通过将多个弱学习器(通常是决策树)组合成一个强学习器来进行预测。在每一轮迭代中,LightGBM 都会根据当前的模型对数据的误差进行加权,训练一个新的树来修正前一个模型的误差。

与传统的梯度提升模型相比,LightGBM 采用了一些创新的技术,使得训练过程更高效,并能够处理更大规模的数据集。

LightGBM 的特点

- 高效的训练速度:

- LightGBM 使用了基于 Histogram-based 的决策树算法,与传统的决策树不同,它通过将特征值离散化为直方图来加速训练。这样可以减少内存使用并加快计算速度,尤其在大规模数据上表现显著。

- 支持类别特征:

- LightGBM 原生支持 类别特征,这意味着你可以直接传入类别数据而无需进行独热编码(One-Hot Encoding),从而节省了内存和计算时间。

- 优化的叶子生长策略:

- LightGBM 使用了 叶子优先(Leaf-wise) 的树生长策略,而传统的 GBDT 通常使用 层级优先(Level-wise) 策略。叶子优先的策略通常能够更好地拟合训练数据,但有时也可能会导致过拟合,因此需要对深度和其他参数进行调节。

- 支持并行和分布式计算:

- LightGBM 提供了多种并行化策略,包括特征并行和数据并行,使得它能够在大规模数据集上训练模型。此外,它还支持分布式训练,适合于处理大规模数据。

- 内存使用更高效:

- LightGBM 在内存使用方面也进行了优化,通过采用高效的数据存储结构,减少了内存占用。

- 高准确性:

- 由于采用了 叶子生长 和其他优化策略,LightGBM 在许多任务中都能提供非常高的预测准确性。

LightGBM 工作原理

LightGBM 通过构建多颗决策树,每一颗树都在前一颗树的基础上进行优化。具体步骤如下:

- 初始化模型:

- 首先,初始化一个基础模型(通常是训练集的均值)。

- 计算残差:

- 计算当前模型对训练数据的预测结果与实际结果之间的误差(残差)。

- 训练新树:

- 训练一颗新的决策树来拟合当前的残差。

- 更新模型:

- 将新训练的树加到当前模型中,并更新模型参数。

- 重复:

- 重复上述过程,直到达到预定的树数或其他停止准则。

核心参数

- num_leaves:控制每棵树的最大叶子节点数,较大的值会增加模型的复杂度,可能导致过拟合。

- max_depth:树的最大深度,限制树的深度可以防止过拟合。

- learning_rate:每次迭代时更新的步长,控制模型的学习速度。

- n_estimators:树的数量,即迭代次数。

- subsample:用于训练每棵树的样本比例,通常用来避免过拟合。

- colsample_bytree:每棵树使用的特征比例,用于随机特征选择,避免过拟合。

- min_child_samples:一个叶子节点所需的最小样本数,减少过拟合。

- feature_fraction:在训练每棵树时,特征的随机子集比例,用来增强模型的泛化能力。

- boosting_type:指定梯度提升的类型,通常选择

gbdt(传统的梯度提升),dart(Dropouts meet Multiple Additive Regression Trees),goss(Gradient-based One-Side Sampling)等。

LightGBM 适用场景

- 大规模数据集:由于 LightGBM 的高效性,它能够处理比传统方法更大的数据集,适用于大规模机器学习任务。

- 分类和回归问题:LightGBM 支持分类(包括二分类和多分类)和回归任务。

- 排名任务:LightGBM 还提供了排名(Ranking)功能,适用于推荐系统等问题。

- 处理类别特征:如果数据中包含类别特征,LightGBM 是一个特别合适的选择。

- 性能优化:当你需要快速训练并且对准确性有较高要求时,LightGBM 是一个非常好的选择。

Python 示例代码

1 | import lightgbm as lgb |

总结

LightGBM 是一个高效且强大的梯度提升树模型,在大规模数据集上具有出色的性能。通过优化训练算法、引入创新的特征处理方式,它能在许多机器学习任务中取得优秀的效果,特别是在需要处理大数据、高维特征和类别特征时,LightGBM 是一个非常合适的选择。

从RDKit中提取物理化学性质

1 | from rdkit import Chem |

LogP值能够表征什么性质

LogP 值(也称为分配系数)是一个重要的物理化学性质,用于表征化合物在两种溶剂中的分配特性,尤其是其亲水性和疏水性的平衡。LogP 是 油/水分配系数 的对数值,表示分子在油相和水相之间的分配程度。具体来说,LogP值越大,分子越倾向于在油相(或有机溶剂)中溶解;而LogP值越小(甚至为负值),分子则更倾向于在水相中溶解。

LogP 值的定义

LogP 是分子在正辛醇和水之间的分配系数的对数值,即:

LogP=log([化合物在正辛醇中的浓度][化合物在水中的浓度])\text{LogP} = \log \left( \frac{[\text{化合物在正辛醇中的浓度}]}{[\text{化合物在水中的浓度}]} \right)

其中:

- P 表示分配系数,是化合物在油相(通常是正辛醇)和水相中的浓度比值。

- LogP 取其对数,通常表示为十进制对数。

LogP 值的意义

- 亲水性与疏水性:

- LogP > 0:表示化合物有较强的疏水性,更容易溶解在油相或有机溶剂中。

- LogP < 0:表示化合物有较强的亲水性,更容易溶解在水相中。

- LogP ≈ 0:化合物的亲水性和疏水性大致平衡,能够在水和油中都较好地溶解。

- 溶解度:

- 化合物的溶解度与其LogP值密切相关。通常,LogP值越大,化合物的疏水性越强,它的水溶性越差;反之,LogP值越小,化合物的亲水性越强,溶解度也可能较高。

- 渗透性和吸收性:

- LogP值对生物体内药物的吸收和渗透性有重要影响。通常,药物分子需要在亲水和疏水性之间找到一个平衡点,以便能够穿越细胞膜(细胞膜的磷脂双层是疏水性的)而不至于在体内溶解度过低。

- 较高的LogP值(疏水性)通常表示分子更易于通过细胞膜,适合用于药物设计,但过高的LogP值可能导致毒性和代谢问题。

- 较低的LogP值(亲水性)通常意味着药物更易溶于水,但可能难以穿透细胞膜。

- 环境中的持久性和迁移性:

- LogP值还可以用来预测化学物质在环境中的迁移性和持久性。疏水性化合物(高LogP值)可能在水生生态系统中积累,而亲水性化合物则可能较容易被水体带走。

LogP在药物化学中的应用

在药物化学和药理学中,LogP是ADMET(吸收、分布、代谢、排泄和毒性)性质的一个重要参数,尤其在药物设计过程中被广泛应用。

- 药物的生物利用度:药物的LogP值能够影响它的生物利用度(bioavailability)。如果LogP值太高,药物可能难以在体内的水相中分布;如果LogP值太低,药物可能无法有效通过细胞膜。

- 血脑屏障渗透性:LogP值对药物能否穿透血脑屏障也有影响,LogP值适中的药物更容易进入大脑组织。

LogP的应用场景总结

- 药物研发:药物的亲水性和疏水性是药效、吸收、分布和代谢的关键因素。LogP值在药物设计中帮助预测药物的生物学行为。

- 环境化学:LogP用来预测化学物质在环境中的持久性、毒性和生态风险。

- 分子筛选:通过计算化合物的LogP值,可以筛选出符合特定要求(如渗透性、溶解度等)的分子。

计算LogP

在实际应用中,可以通过实验测量或者QSAR模型(定量结构-活性关系模型)来预测LogP值。常见的计算工具包括:

- 计算化学方法(如模拟溶剂分配系数)。

- 分子指纹和机器学习方法,利用已有的化学结构数据来预测LogP值。

结论

LogP值是一个多用途的参数,能够帮助表征化合物的亲水性和疏水性平衡,对于药物化学、环境科学等领域的研究和应用具有重要意义。对于药物分子,适中的LogP值是穿越生物膜的关键,同时也关系到药物的溶解度和生物利用度。

画图:每条线只显示一个点和误差棒

1 | import matplotlib.pyplot as plt |

机器学习寻找最优配比一般流程

使用 机器学习 来实现分子配比优化是一个非常常见的策略,尤其当我们没有精确的公式来描述分子之间的关系时,机器学习可以帮助我们学习出一个模型,用来预测在给定配比下的目标值。然后,基于这个模型,我们可以使用优化算法来找到最优的配比。

步骤概述

- 数据准备:首先,我们需要有足够的历史数据,这些数据应该包含不同的分子配比和对应的目标值。

- 机器学习建模:我们可以使用回归模型来拟合分子配比和目标值之间的关系。常用的回归模型包括线性回归、决策树回归、随机森林回归、XGBoost 等。

- 优化:使用训练好的机器学习模型来预测目标值,然后使用优化算法(如贝叶斯优化、粒子群优化等)来找到能够最大化或最小化目标值的最佳配比。

具体实现步骤

1. 数据准备

假设我们有一个数据集,包含了分子配比和对应的目标值。下面是一个示例数据集:

1 | import pandas as pd |

2. 机器学习建模

选择一种回归算法来拟合模型。比如,我们可以使用 随机森林回归 来建立一个预测模型,预测给定配比下的目标值。

1 | from sklearn.ensemble import RandomForestRegressor |

在这个例子中,我们使用 随机森林回归模型 来拟合分子配比与目标值之间的关系,训练数据集包含了 80% 的数据,测试数据集包含了 20% 的数据。模型拟合后,我们可以通过 model.predict 来预测目标值。

3. 优化模型

一旦我们有了训练好的模型,我们就可以使用 优化算法 来找到最优的分子配比。这一过程可以通过 贝叶斯优化、粒子群优化(PSO) 或其他优化方法来实现。

我们使用 skopt 库的 贝叶斯优化 来寻找最佳配比。

1 | from skopt import gp_minimize |

4. 可视化优化结果

可以通过 matplotlib 可视化优化过程以及最优配比的分布。

1 | import matplotlib.pyplot as plt |

总结

- 数据建模:我们首先使用机器学习回归模型(如随机森林回归)来拟合分子配比与目标值之间的关系。我们使用了分子配比作为输入特征,目标值作为标签。

- 优化:在训练好回归模型后,使用贝叶斯优化等优化算法来寻找最佳的分子配比。优化目标可以是最大化或最小化目标值,这取决于你的需求。

- 结果:通过优化过程,我们找到了最优的分子配比。通过模型的预测,我们可以进一步探索不同配比下的目标值

扩展

- 更复杂的模型:如果你认为目标函数与配比之间的关系较复杂,可以尝试更复杂的回归模型,如 梯度提升树(XGBoost、LightGBM),或者使用神经网络来进行建模。

- 多目标优化:如果你有多个目标需要同时优化(比如最大化某个性能指标并最小化成本),可以使用 多目标贝叶斯优化 或者 Pareto 前沿优化。

- 优化约束:如果有配比的约束条件(如配比的和必须为 1),可以在优化算法中添加这些约束条件。

什么是collinearity?

Collinearity(共线性)是统计学和回归分析中常见的概念,指的是在多个自变量(解释变量)之间存在高度的线性关系。当两个或多个自变量彼此之间呈现高度相关性时,就会发生共线性现象。

共线性的含义

- 完全共线性:如果自变量之间存在完全的线性关系(例如,

X2 = 2 * X1),那么就存在完全共线性。此时,某些自变量是可以用其他自变量的线性组合来精确预测的。 - 近似共线性:在实际数据中,自变量之间往往不会有完全的线性关系,但如果它们的相关性非常高(例如,相关系数接近 1 或 -1),这也会导致共线性问题。

共线性的影响

在回归分析中,尤其是多元线性回归中,共线性问题会对模型产生不利影响,主要体现在以下几个方面:

- 系数估计的不稳定性:

- 当自变量高度相关时,回归模型中的系数估计变得不稳定,意味着模型参数对数据的微小变化非常敏感。即使数据有小的扰动,也可能导致回归系数发生大的变化。

- 标准误差增大:

- 高度相关的自变量会使回归系数的标准误差增大,这意味着模型的预测能力下降,并且可能导致对某些自变量影响的估计不准确。

- 多重共线性与显著性测试:

- 共线性会导致部分自变量的p值增大,可能会错误地认为某些重要的自变量不显著,而实际上它们可能是有影响的。

如何检测共线性

- 相关矩阵:

- 计算自变量之间的相关系数矩阵。如果自变量之间的相关系数非常高(接近 1 或 -1),可能存在共线性问题。

- 方差膨胀因子(VIF, Variance Inflation Factor):

- VIF 是用来量化共线性的常用工具。VIF 值表示一个自变量的方差是由于其他自变量的影响而膨胀了多少。如果某个自变量的 VIF 值大于 10,通常认为该自变量存在较强的共线性。

- 计算 VIF 的公式是: $VIF=\frac{1}{1 - R^2}$ 其中,$R^2$ 是将某一自变量对其他自变量进行回归时的决定系数。

- 条件数(Condition Number):

- 通过计算设计矩阵的条件数来检查共线性问题。较大的条件数(通常大于 30)表明共线性问题可能较严重。

如何处理共线性

- 删除相关性高的自变量:

- 如果某些自变量之间高度相关,可以选择删除其中一个或几个相关性高的自变量,保留最具代表性的变量。

- 合并相关自变量:

- 可以通过主成分分析(PCA)等降维技术,将高度相关的自变量合并成一个新的变量。

- 增加样本量:

- 有时增加样本量有助于减少共线性带来的影响,特别是在数据本身存在噪声时。

- 正则化方法:

- 使用正则化方法(如岭回归、Lasso回归)来减少模型对共线性敏感的程度。正则化方法通过对回归系数施加惩罚,使得模型更加稳定。

示例:如何检查共线性

假设你有一个数据集,其中包含三个自变量 X1, X2, X3。你可以使用 Python 的 statsmodels 或 scikit-learn 来计算 VIF 或相关系数矩阵,来检测共线性。

1 | import pandas as pd |

总结

共线性 是指多个自变量之间存在高度的线性关系,这可能导致回归分析中的模型不稳定、预测不准确。通过计算相关矩阵、VIF 或条件数,可以检测共线性。如果共线性问题较严重,通常需要通过删除变量、合并变量、增加样本量或使用正则化方法来解决。

超参数优化

- optuna

- A hyperparameter optimization framework

目标:

- 5-fold 交叉验证:在每个超参数组合下进行 5 次交叉验证,计算每次验证的误差(如 MAE)。

- 500 次试验:使用 Optuna 进行 500 次超参数优化。

- 存储最佳超参数和预测值:优化结束后,存储每次试验的最佳超参数以及对应的预测值。

代码实现:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86import optuna

from sklearn.model_selection import train_test_split, KFold

from sklearn.ensemble import RandomForestRegressor # 例子中使用随机森林回归模型

from sklearn.metrics import mean_absolute_error

import numpy as np

import pandas as pd

# 加载数据集

# 假设你的数据集已经加载,X 是特征,y 是目标变量(温度)

# X, y = load_your_dataset() # 替换为你的数据集

# 示例:使用合成数据集

from sklearn.datasets import make_regression

X, y = make_regression(n_samples=100, n_features=10, noise=0.1, random_state=42)

# 定义 Optuna 的目标函数(包括 5-fold 交叉验证)

def objective(trial):

# 定义需要优化的超参数

n_estimators = trial.suggest_int('n_estimators', 50, 200) # 树的数量

max_depth = trial.suggest_int('max_depth', 3, 10) # 树的最大深度

# 创建模型并使用超参数

model = RandomForestRegressor(n_estimators=n_estimators, max_depth=max_depth, random_state=42)

# 使用 5-fold 交叉验证

kf = KFold(n_splits=5, shuffle=True, random_state=42)

mae_scores = []

predictions = []

# 进行 5-fold 交叉验证

for train_index, test_index in kf.split(X):

X_train, X_test = X[train_index], X[test_index]

y_train, y_test = y[train_index], y[test_index]

# 在训练集上训练模型

model.fit(X_train, y_train)

# 在测试集上进行预测

y_pred = model.predict(X_test)

predictions.append(y_pred)

# 计算当前 fold 的 MAE

mae = mean_absolute_error(y_test, y_pred)

mae_scores.append(mae)

# 计算 5 个折叠的平均 MAE

mean_mae = np.mean(mae_scores)

# 返回 MAE,作为目标函数值(优化时会最小化它)

return mean_mae

# 创建一个研究对象(study)并指定目标是最小化 MAE

study = optuna.create_study(direction='minimize') # 目标是最小化 MAE

study.optimize(objective, n_trials=500) # 执行 500 次试验

# 输出最佳试验的超参数和对应的 MAE

print(f"最佳试验: {study.best_trial}")

print(f"最佳超参数: {study.best_trial.params}")

print(f"最佳 MAE: {study.best_value}")

# 存储最佳的超参数

best_n_estimators = study.best_trial.params['n_estimators']

best_max_depth = study.best_trial.params['max_depth']

# 使用最佳超参数创建模型

best_model = RandomForestRegressor(n_estimators=best_n_estimators, max_depth=best_max_depth, random_state=42)

# 用整个数据集重新训练最佳模型

best_model.fit(X, y)

# 存储每次试验的预测值

all_predictions = np.array(predictions).flatten()

# 将结果存入 DataFrame 以便后续分析

results_df = pd.DataFrame({

'trial': range(1, 501),

'predicted_temperatures': all_predictions

})

# 保存结果到 CSV 文件(可以根据需要选择不同的存储方式)

results_df.to_csv('optuna_trial_predictions.csv', index=False)

# 可选:保存最佳模型

import joblib

joblib.dump(best_model, 'best_model.pkl')

代码说明:

- 加载数据集:

- 我们使用了

make_regression来生成一个简单的回归数据集(假设X是特征,y是目标变量——温度)。 - 你可以替换成你自己的数据集(通过

load_your_dataset()来加载实际数据)。

- 我们使用了

- **目标函数 (

objective)**:- 我们使用了

RandomForestRegressor作为示例模型,优化的超参数包括n_estimators(树的数量)和max_depth(树的最大深度)。 - 在每个超参数组合下,通过 5-fold 交叉验证 进行训练和评估。

- 每次折叠计算 MAE(Mean Absolute Error,平均绝对误差),然后返回所有折叠的平均 MAE 作为目标函数值,Optuna 会最小化这个值。

- 我们使用了

- 创建和优化 Study:

- 使用

optuna.create_study(direction='minimize')创建优化研究对象,设置目标是最小化 MAE。 study.optimize(objective, n_trials=500)进行 500 次超参数优化试验。

- 使用

- 存储最佳超参数和预测值:

- 优化结束后,输出最优超参数和对应的 MAE。

- 将每次试验的预测结果存入

DataFrame,并保存为 CSV 文件。

- 保存最佳模型:

- 使用

joblib.dump()保存训练好的最佳模型,以便后续加载和使用。

- 使用

结果输出:

- 最佳超参数:

study.best_trial.params存储了找到的最佳超参数配置(例如n_estimators=150,max_depth=6)。 - 最佳 MAE:

study.best_value显示了最小的 MAE,即优化过程中的最佳性能。 - 预测结果:每个试验的预测温度值都存储在

optuna_trial_predictions.csv中,方便后续分析。

总结:

通过 Optuna 和 5-fold 交叉验证,你可以高效地优化模型的超参数,减少过拟合,提升模型的泛化能力。优化后的模型可以用于实际预测,并且你可以保存和分析每次试验的预测结果。

常见ML方法特点

SVR是一种广泛使用的算法,它采用核方法在特征空间中识别最优超平面,使每个数据点到该超平面的12范数最小化。

KNN是一个简单的“懒惰模型”,它根据新数据与训练数据点的接近程度生成预测。它不需要预训练,因此可以进行快速、实时的预测。

MLP是一种人工神经网络,它由多个相互连接的层组成,可以处理非线性估计;它的学习过程包括前向传播、成本计算和反向传播以调整权重,并利用适当的损失函数和优化算法。

DT提供了一个树形模型,通过应用一系列决策规则来进行预测。虽然简单易懂,但它缺乏神经网络等模型的复杂性。

RF是决策树的集合,利用套袋技术来平均单个树的预测,从而在保持偏差的同时减少模型方差。该模型采用随机特征选择来降低单个树之间的相关性。

ET在决策树形成过程中增加了一层随机性。虽然它可能产生次优的单个树,但通过减少预测偏差和更广泛地探索数据集,集成往往表现良好。

AdaBoost结合了多个弱分类器来生成一个强的、自适应的模型;它为训练实例分配权重,允许后续模型将专注于具有挑战性的案例并提高整体性能。

由Yandex开发的CatBoost特别适合分类特征,与其他梯度增强算法相比具有明显的优势

GBM采用决策树集合并迭代提高性能,使其成为各种ML应用程序的热门选择

LGBM通过集成降低计算负担而不显著影响性能的技术来改进传统的梯度增强,从而实现更快的模型训练和更有效的预测

HistGB是一般梯度增强框架的速度优化扩展。通过只考虑箱子的端点,它加速了训练过程。

XGBoost提供了并行处理和过拟合调节等优点。它采用复杂的技术来处理学习错误,使其成为预测建模的合适选择。

什么是kernel method?

核方法(Kernel Method) 是一种在机器学习和统计学中广泛使用的技术,它通过将输入数据映射到一个高维空间,从而能够在高维空间中进行线性分离和建模,即使在原始输入空间中数据可能是非线性可分的。

核方法的核心思想是使用一个称为“核函数”的数学函数来计算输入数据在高维空间中的内积,而无需显式地将数据映射到高维空间。这使得计算变得高效且不需要处理高维空间中的复杂计算。

核方法的基本概念

- 映射到高维空间:

- 在很多机器学习任务中,数据可能在低维空间中是非线性可分的(比如在二维平面中两个类别的数据点可能不能被一条直线分开)。核方法通过将数据映射到一个更高维的空间,使得数据在高维空间中变得线性可分。

- 这种映射不一定需要显式地进行。通过核函数的技巧,计算数据在高维空间中的内积(而不是显式地计算映射后的数据)可以非常高效。

- 核函数:

- 核函数是用来计算数据在高维空间中内积的函数。常见的核函数包括:

- 线性核:

K(x, y) = x^T y,对应于没有进行任何映射,直接计算输入数据的内积。 - 多项式核:

K(x, y) = (x^T y + c)^d,可以用于捕捉数据的多项式关系。 - 高斯径向基核(RBF 核):

K(x, y) = exp(- ||x - y||^2 / (2 * sigma^2)),适用于很多非线性问题,尤其是在高维数据中非常有效。 - Sigmoid 核:

K(x, y) = tanh( x^T y + c ),与神经网络中的激活函数类似。

- 线性核:

- 核函数是用来计算数据在高维空间中内积的函数。常见的核函数包括:

- 优势:

- 无显式映射:通过核函数,核方法能够有效地避免显式地进行高维空间的映射,从而减少计算复杂度。

- 非线性模型:核方法能够处理非线性问题,而不需要手动选择非线性特征转换。

- 灵活性:不同的核函数可以适应不同类型的数据和问题。

核方法的常见应用

- 支持向量机(SVM):

- 核方法最著名的应用之一是在支持向量机(SVM)中。SVM 是一种强大的分类方法,特别是在高维空间中非常有效。通过使用核函数,SVM 可以处理非线性分类问题。

- 例如,使用高斯径向基核(RBF)函数,SVM 可以将原本非线性可分的数据映射到高维空间,在高维空间中使用超平面进行线性分类。

- 主成分分析(PCA):

- 核PCA(Kernel PCA)是一种通过使用核函数来进行非线性主成分分析的方法。传统的PCA是线性的,通过核方法,PCA也可以用于处理非线性数据。

- 回归问题:

- 在回归问题中,核方法可以帮助建立非线性回归模型。通过核函数,支持向量回归(SVR)等方法可以对非线性数据进行建模。

- 聚类:

- 核方法也可用于聚类,尤其是在支持向量聚类(SVC)中。通过映射到高维空间,核聚类方法能够在非线性空间中寻找聚类结构。

核方法的数学背景

- 再定义内积:

- 核方法的关键是“核函数”本质上是计算数据在某一高维空间中的内积(也称为特征空间中的内积)。假设有一个映射函数

Φ(x),将数据x映射到高维空间。核方法通过核函数K(x, y) = ⟨Φ(x), Φ(y)⟩来计算数据在高维空间中的内积。

- 核方法的关键是“核函数”本质上是计算数据在某一高维空间中的内积(也称为特征空间中的内积)。假设有一个映射函数

- 核技巧(Kernel Trick):

- 核技巧允许我们直接计算数据在高维空间中的内积,而无需显式地计算映射后的数据。这极大地提高了计算效率,尤其是在高维数据处理中。

- 例如,通过 RBF 核函数,我们不需要计算映射后的数据点,而是通过直接计算它们的核函数值来实现相同的效果。

核方法的局限性

计算复杂度

:

- 核方法的计算量可能会随着数据集的增大而显著增加,特别是当数据集包含大量样本时。尽管核技巧能够避免显式的高维映射,但在大规模数据集上计算核矩阵仍然是一个挑战。

选择合适的核函数

:

- 选择合适的核函数对模型的性能非常重要。不合适的核函数可能导致模型效果不佳。

总结

核方法是一种非常强大的技术,它通过核函数将数据映射到高维空间,使得在高维空间中进行的计算和学习变得更加简单,尤其是在处理非线性问题时。在支持向量机、主成分分析和回归等多种机器学习方法中,核方法都得到了广泛的应用。它的核心优势是通过核技巧避免了显式映射数据,提高了计算效率。

贝叶斯优化优化的是什么?

GPT-4o

贝叶斯优化(Bayesian Optimization)是一种用于优化 黑箱函数(即那些我们不知道其显式形式、计算代价高、或者在某些情况下不可微的函数)的优化方法。与传统的优化方法(如梯度下降)不同,贝叶斯优化不需要目标函数的显式表达式或计算梯度,它通过构建目标函数的概率模型,并利用该模型来决定如何选择下一步进行评估。

贝叶斯优化主要用于 超参数优化,即优化机器学习模型的超参数。通常,超参数的选择会极大地影响模型的性能,而贝叶斯优化能够有效地在较少的实验次数下找到合适的超参数。

具体优化的内容:

- 超参数优化:

- 在机器学习中,超参数是影响模型训练过程和性能的重要参数,例如:

- 神经网络的学习率、隐藏层的神经元数量

- 支持向量机(SVM)的核函数参数、C参数

- 随机森林中的树的数量、最大深度

- 贝叶斯优化通过选择超参数空间内的合适点来逐步提高模型的性能,而不需要暴力遍历所有的超参数组合。

- 在机器学习中,超参数是影响模型训练过程和性能的重要参数,例如:

- 目标函数的最小化或最大化:

- 贝叶斯优化的核心是通过概率模型(通常是高斯过程模型)来逼近目标函数(即通过评估超参数配置得到的模型性能,如准确率、均方误差等)。然后,基于当前模型,选择最有可能提供最优解的超参数配置进行评估。

- 减少评估次数:

- 与网格搜索或随机搜索不同,贝叶斯优化通常能够在更少的实验次数下找到合适的超参数组合。它通过逐步更新目标函数的概率模型来提高优化效率。

贝叶斯优化的工作原理:

- 构建代理模型:

- 在贝叶斯优化中,代理模型通常是一个统计模型(例如高斯过程),它用于近似目标函数的真实形式。这个模型基于已有的超参数评估结果进行训练。

- 选择下一个试验点:

- 通过一个 采集函数(Acquisition Function)来决定下一个评估点的位置。采集函数的目标是平衡 探索(选择尚未尝试的超参数区间)和 开发(选择当前模型预测最优的超参数)。

- 评估目标函数:

- 在选定的点上评估目标函数(即训练模型并计算其性能)。

- 更新代理模型:

- 根据新评估的结果更新代理模型,并重复上述过程,直到满足停止准则(如达到最大评估次数,或者性能已达到预期)。

贝叶斯优化的优点:

- 高效性:相比于网格搜索和随机搜索,贝叶斯优化通过代理模型和采集函数,通常能够在较少的尝试次数下找到优质的超参数配置。

- 适用于昂贵的黑箱函数:对于训练时间长、计算代价高的模型(如深度学习模型),贝叶斯优化特别有效,因为它能够减少模型评估次数。

- 平衡探索与利用:贝叶斯优化在搜索过程中能够自然地平衡探索(选择未探索的区域)和利用(选择当前认为最优的区域)。

贝叶斯优化的应用场景:

- 超参数优化:如机器学习模型的训练过程中的超参数调整(例如学习率、正则化参数等)。

- 实验设计:在科学实验中,选择最合适的实验条件来最大化某个输出。

- 结构优化:如工程领域中优化设计参数。

- 自动化调优:在生产环境中自动调整系统的运行参数。

Python中的贝叶斯优化

贝叶斯优化在 Python 中可以通过多个库实现,最常用的库是 scikit-optimize 和 Spearmint。其中,scikit-optimize 提供了一个易于使用的接口,帮助我们进行超参数优化。

示例代码(使用scikit-optimize库进行贝叶斯优化)

1 | from skopt import BayesSearchCV |

解释:

- 模型选择:我们使用

RandomForestClassifier作为要优化的机器学习模型。 - 超参数空间定义:在

param_space中,我们为n_estimators、max_depth和min_samples_split设置了超参数范围,这些超参数将通过贝叶斯优化进行调整。 - 贝叶斯优化:

BayesSearchCV是scikit-optimize提供的贝叶斯优化的封装,它将自动执行超参数优化,并通过交叉验证评估每个超参数组合的表现。 - 结果输出:输出最佳的超参数组合及其对应的性能。

总结:

贝叶斯优化是一种有效的优化技术,尤其适用于超参数调优和需要大量计算资源的任务。它通过代理模型和采集函数来智能选择优化方向,从而减少评估次数,提高优化效率。

盐水作为水合物抑制剂

Subsea wells extracting oil and gas often contain saline water, acting as a natural inhibitor due to the presence of electrolytes such as NaCl, KCl, and CaCl2 within the brine. The strong bonds between water and salt ions play a crucial role in inhibiting hydrate formation, as water is more attracted to ions than the hydrate structure

水和盐离子之间的强键在抑制水合物形成中起着至关重要的作用,因为水更容易被离子吸引,而不是水合物结构

E.D. Sloan Jr., C.A. Koh, Clathrate hydrates of natural gases, CRC Press, 2007.

Chemical Engineering Journal 498 (2024) 155664

2024-11月

什么是Customized Federated kernel Regression

Chemical Engineering Journal 498 (2024) 155664

ChatGPT-4o

Customized Federated Kernel Regression (定制化联邦核回归) 是一种结合了 联邦学习(Federated Learning)和 核回归(Kernel Regression)的方法,用于在多个分散的数据源上进行机器学习建模,同时保护数据隐私和安全性。

联邦学习(Federated Learning)概述

- 联邦学习是一种分布式机器学习方法,它允许多个设备或数据源在保持数据本地化的同时,共同训练一个机器学习模型。在联邦学习中,数据不会被集中存储和处理,而是通过一种协作的方式,将本地计算的更新(例如梯度或模型参数)发送到中央服务器,后者合并这些更新来改善全局模型。

- 优点: 保证数据隐私,因为数据不会离开本地设备或服务器。

- 缺点: 在跨多个设备上进行计算时,面临通信开销和数据异质性等挑战。

- 联邦学习是一种分布式机器学习方法,它允许多个设备或数据源在保持数据本地化的同时,共同训练一个机器学习模型。在联邦学习中,数据不会被集中存储和处理,而是通过一种协作的方式,将本地计算的更新(例如梯度或模型参数)发送到中央服务器,后者合并这些更新来改善全局模型。

核回归(Kernel Regression)

- 核回归是一种非参数的回归方法,通常用于处理复杂的非线性数据。它利用 核技巧(Kernel Trick)将输入数据映射到高维特征空间,从而能够通过线性方法处理非线性问题。核回归常用于场景中,数据集可能是高维的,或者存在明显的非线性关系。

- 优点: 不需要明确假设数据的分布形式,能够灵活处理复杂数据。

- 缺点: 计算开销较大,尤其是当数据量较大时。

- 核回归是一种非参数的回归方法,通常用于处理复杂的非线性数据。它利用 核技巧(Kernel Trick)将输入数据映射到高维特征空间,从而能够通过线性方法处理非线性问题。核回归常用于场景中,数据集可能是高维的,或者存在明显的非线性关系。

定制化(Customized)

- 在“定制化联邦核回归”中,“定制化”通常意味着根据特定的应用场景或需求对方法进行调整或优化。这可以包括:

- 自定义的核函数:根据数据的性质选择合适的核函数(例如高斯核、多项式核等)。

- 优化的联邦学习框架:根据设备的通信能力、计算能力和数据分布,定制不同的学习策略(例如调整联邦学习中的聚合算法)。

- 特定的回归模型:设计特定的回归策略,以便处理不同的数据或业务需求。

- 在“定制化联邦核回归”中,“定制化”通常意味着根据特定的应用场景或需求对方法进行调整或优化。这可以包括:

联邦核回归的组合

“定制化联邦核回归”的核心思想是将核回归的优势与联邦学习的隐私保护相结合。这种方法能够处理分散在多个设备或客户端上的非线性回归问题,并且在保证隐私的前提下,进行高效的建模。

在联邦核回归中,每个数据源(例如设备或客户端)执行以下操作:

- 局部训练:在本地数据上执行核回归训练。由于数据是分散的,训练通常是非全局的。

- 本地模型更新:每个设备计算本地模型的更新(如模型参数或核函数相关的统计量)。

- 聚合更新:设备将本地更新通过联邦学习的方式传输到中央服务器,服务器对这些更新进行合并,从而更新全局模型。

通过使用核回归,即使数据之间存在非线性关系,模型仍然能够捕捉到这些复杂的模式。同时,通过联邦学习,多个设备能够共同训练模型,而无需暴露各自的私有数据。

应用场景

- 智能医疗:不同医院或医疗机构拥有患者数据,但由于隐私原因,不能共享数据。通过定制化联邦核回归,每个医院可以训练一个本地模型,并将更新汇总到中央服务器,保护患者隐私的同时获得更好的预测性能。

- 金融领域:多个金融机构可以联合训练一个信用评分模型,尽管每个机构的数据是私密的,但仍然可以利用联邦学习和核回归来提高评分模型的准确性。

- 物联网:多个物联网设备(如传感器)可以在本地进行回归分析,利用定制化核回归对非线性数据建模,同时通过联邦学习汇聚信息来改善整体预测。

挑战和前景

- 通信开销:由于每个设备都需要与中央服务器交换模型更新,可能导致通信负担过重,特别是当数据量较大时。

- 数据异质性:不同客户端的本地数据可能具有不同的分布,如何在此条件下高效地聚合模型更新仍然是一个研究问题。

- 核函数选择:如何选择适当的核函数来适应不同的数据类型和任务是核回归中需要解决的问题。

总结

- 定制化联邦核回归结合了联邦学习和核回归的优势,既能够处理非线性回归问题,又能保证数据隐私,是一个非常有前景的方法。随着隐私保护需求的增加和分布式计算能力的提高,这种方法将在智能医疗、金融服务、物联网等领域发挥重要作用。

现有微观测试手段尚不能真正连续观测水合物的生长和分解过程

[1]刘昌岭,张永超,纪云开,等.天然气水合物微观测试技术与应用进展[J].海洋地质与第四纪地质,2024,44(03):136-148.DOI:10.16562/j.cnki.0256-1492.2023102301.

ChatGPT问答

如果我有三个特征,三列中,第一列为1 1 1 1 1 1 0 0 0 0 0 0 0,第二列为 0 0 0 0 0 0 1 1 1 1 0 0 0, 第三列为 0 0 0 0 0 0 0 0 0 0 1 1 1,怎么来处理这三个特征呢,使其正态分布

你提到的三个特征列中,第一列、第二列和第三列看起来像是二分类特征。由于这些特征本身已经是离散的(0 和 1),通常这些特征不符合正态分布的假设,因此我们不建议直接通过标准化或正态化处理它们。

但是,如果你的目标是使这些特征更加符合机器学习模型对数据的假设(例如,要求特征符合正态分布),你可以尝试以下几种方法来处理这些特征:

标准化(Standardization):虽然这些特征本身是二值的(0 或 1),你仍然可以应用标准化方法。标准化将每个特征的均值调整为 0,标准差调整为 1。对于这些二值特征,这个操作会将数据的中心化和方差调整为 0 和 1,从而在一定程度上使其适应某些算法(如支持向量机、线性回归等)的需求。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24import numpy as np

from sklearn.preprocessing import StandardScaler

# 假设你的数据在一个numpy数组中,名为 data

data = np.array([[1, 0, 0],

[1, 0, 0],

[1, 0, 0],

[1, 0, 0],

[1, 0, 0],

[1, 0, 0],

[0, 1, 0],

[0, 1, 0],

[0, 1, 0],

[0, 1, 0],

[0, 0, 1],

[0, 0, 1],

[0, 0, 1]])

# 使用 StandardScaler 进行标准化

scaler = StandardScaler()

data_standardized = scaler.fit_transform(data)

print(data_standardized)归一化(Min-Max Scaling):归一化方法将数据缩放到一个固定的范围(通常是 [0, 1])。对于二值特征,这种方法的效果较好,因为它将所有特征值映射到统一的范围内。

对于已经是二进制的特征(0 或 1),

log转换或Box-Cox转换不是有效的方法。这些方法通常适用于具有连续数值且大于零的特征。如果你想将特征转换为接近正态分布的形式,通常会要求特征是连续的或者至少是有较大变化范围的。对于这种二分类特征,可以考虑其他的编码方式,或者直接使用这些特征进行建模,而不强行让其符合正态分布。

One-Hot 编码:对于具有二值特征的类别数据,如果这些特征代表不同的类别,最好使用 One-Hot 编码。这会创建多个新的特征列,并为每个类别值分配一个二进制指示符(0 或 1)。

1

2

3

4

5

6

7

8

9

10

11

12

13

14import pandas as pd

# 假设你的数据是 DataFrame 格式

df = pd.DataFrame({

'Feature1': [1, 1, 1, 1, 1, 1, 0, 0, 0, 0, 0, 0, 0],

'Feature2': [0, 0, 0, 0, 0, 0, 1, 1, 1, 1, 0, 0, 0],

'Feature3': [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 1, 1]

})

# 使用 pd.get_dummies() 进行 One-Hot 编码

df_encoded = pd.get_dummies(df, columns=['Feature1', 'Feature2', 'Feature3'], drop_first=False)

print(df_encoded)如果你正在使用基于树的模型(例如,随机森林、梯度提升树等),你可以直接使用这些二值特征,因为这些模型对于数据的分布不那么敏感。树模型通常不要求特征符合正态分布,因此即使数据是二值的,也能取得较好的效果。

2024-10月

如果箱线图的异常值很多可以作为训练集吗?

gpt-4o

箱线图中识别出的异常值可以作为训练集的一部分,但要考虑以下几个方面:

- 异常值的来源

自然现象:如果异常值是数据的真实反映,且在实际应用中可能出现,那么保留这些值对模型训练是有意义的。

测量误差:如果异常值是由于测量错误或数据录入错误导致的,可能需要考虑删除或纠正这些值,以防它们对模型产生负面影响。 - 模型的鲁棒性

一些机器学习模型对异常值不敏感(如决策树、随机森林),在这些模型中,保留异常值可能不会显著影响性能。

其他模型(如线性回归)可能会受到异常值的影响,导致性能下降。在这种情况下,可能需要进行处理或删除。 - 数据集的整体性

如果数据集的大小足够大,异常值的存在可能不会显著影响模型的学习。相反,如果数据集较小,异常值可能会对结果产生较大影响。 - 特征工程

可以考虑对异常值进行处理,例如分箱、变换或创建额外的特征来标识异常值,从而让模型了解这些值的特性。

总结

异常值可以作为训练集的一部分,但在使用之前,需要仔细分析这些值的性质和对模型的潜在影响。适当的处理方法能够帮助提升模型的性能和可靠性。

mW水力场甲烷水合物相图预测

Reparameterization of the mW model to accurately predict the experimental phase diagram of methane hydrate

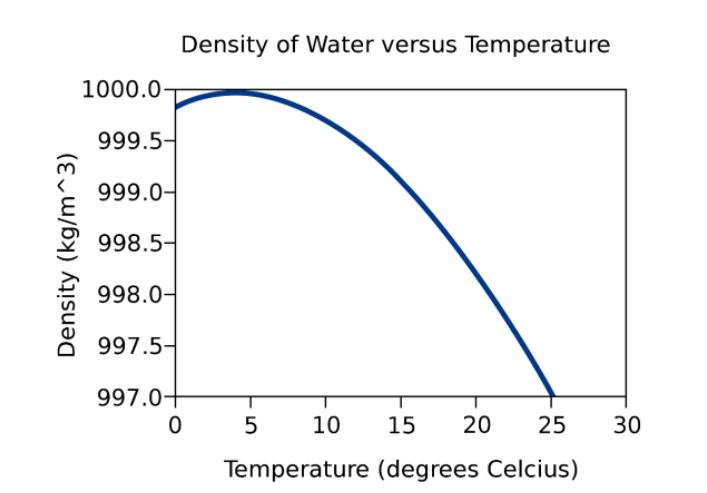

水在多少度的时候密度最大?

水的密度在 4°C(摄氏度)时达到最大值。这是由于水的独特分子结构和氢键作用,导致其在这个温度下的排列方式使得分子之间的距离最小,从而密度最大。

当温度高于或低于 4°C 时,水的密度会逐渐减小。这也是为什么冰会浮在水面上的原因,因为冰的密度比液态水小。

ChatGPT-4o 也可能会犯错。请核查重要信息。

大孔水合物相平衡和体块基本一致

Experimental observation of formation and dissociation of methane hydrate in a micromodel

Chemical Engineering Science 248 (2022) 117227

Different hydrate formation behaviors cause various hydrate dissociation phenomena.

一个微流体图片采集系统需要什么:

- 显微镜(Changrong S-T)

- CCD (Aptina-6.0)

- 电脑+图片处理软件(Image-Pro Plus6.0)

微观孔道甲烷水合物形成分解实验流程:

- 首先将甲烷和水/盐水共注入微模型。(由于微模型的多孔结构,注入的气相可以分散并以甲烷气泡的形式被困在微模型的微通道中)

- 操作压力维持在4mpa左右。

- 采用冰-水合物生成方法,缩短水合物生成的诱导时间

- 冷却水浴提供了冰形成所需的零度以下的温度。

- 当微观模型中形成冰相时,升高温度使冰融化并诱导水合物形成。水合物在超过解离温度后开始解离。

怎么进行特征工程?

特征工程是提升机器学习模型性能的关键步骤之一,它包括从原始数据中提取有用的特征、转换特征、选择合适的特征等。以下是一些常用的特征工程方法,以及如何在实际项目中应用这些方法。

特征提取:从原始数据中提取新的、有意义的特征,能够更好地帮助模型进行学习。例如:

- 时间序列数据:从日期中提取年、月、日、周数、季度等。

- 文本数据:使用

TF-IDF、Word2Vec等方法将文本数据转化为数值特征。 - 图像数据:提取图像的边缘特征、颜色直方图等。

特征转换:将特征进行数学转换或重新构造,以增强数据对模型的表达能力。

对数变换:对偏态分布的数据取对数,可以让数据更接近正态分布。

标准化与归一化:

- 标准化(Standardization):将特征的均值调整为0,标准差调整为1。

- 归一化(Normalization):将数据缩放到 [0, 1] 或 [-1, 1] 的区间内。

Box-Cox 变换:适用于偏态分布数据的变换,使数据更接近正态分布。

特征组合:创建新的特征或组合多个特征,以便更好地捕捉特征之间的关系。

交互特征:创建两个特征的乘积或比值,例如

feature1 * feature2。多项式特征:使用多项式扩展特征,例如

feature1^2,可以捕捉到非线性关系。示例代码(交互特征和多项式特征):

1

2

3from sklearn.preprocessing import PolynomialFeatures

poly = PolynomialFeatures(degree=2, interaction_only=True)

X_poly = poly.fit_transform(X)

特征选择:选择对模型有较大影响的特征,可以提高模型的性能并减少过拟合。

- 方差阈值:移除低方差特征,假设这些特征对目标变量的区分度较低。

- 相关性分析:通过皮尔森相关系数移除高度相关的特征。

- 基于模型的特征选择:使用

Lasso回归、树模型(例如RandomForest)等选择特征。

特征编码:将分类变量(类别特征)转化为模型可以理解的数值形式。

Label Encoding:将每个类别映射为一个整数,用于有顺序关系的类别。

One-Hot Encoding:为每个类别创建一个独立的二进制特征,用于无顺序关系的类别。

示例代码(Label Encoding 和 One-Hot Encoding):

1

2

3

4

5

6

7

8

9from sklearn.preprocessing import LabelEncoder, OneHotEncoder

# Label Encoding

label_encoder = LabelEncoder()

y_encoded = label_encoder.fit_transform(y)

# One-Hot Encoding

one_hot_encoder = OneHotEncoder(sparse=False)

X_one_hot_encoded = one_hot_encoder.fit_transform(X_categorical)

缺失值处理:处理数据中的缺失值,以避免对模型造成影响。

均值填充:用特征的均值填充缺失值。

中位数填充:用特征的中位数填充缺失值,适用于有异常值的数据。

插值法:对于时间序列数据,可以使用插值来填补缺失值。

示例代码(均值填充):

1

2

3from sklearn.impute import SimpleImputer

imputer = SimpleImputer(strategy='mean')

X_imputed = imputer.fit_transform(X)

特征降维:将高维数据降维,保留重要信息,减少噪声,提升模型性能。

PCA(主成分分析):将高维数据投影到较低维空间。

t-SNE/UMAP:非线性降维方法,适用于数据可视化。

示例代码(PCA):

1

2

3

4from sklearn.decomposition import PCA

pca = PCA(n_components=2)

X_reduced = pca.fit_transform(X)

2024-9月

PCA一般降维到几维

GPT-4o

降维到几维通常取决于数据的特性、任务的需求以及模型的复杂性。没有固定的标准答案,但以下几个原则可以帮助你确定降维的合适维数:

方差解释率(Explained Variance Ratio)

- 在使用 PCA(主成分分析)时,通常会查看每个主成分解释的方差比例。一般来说,前几个主成分能够解释大部分的数据方差。

- 通常的做法是选择那些能够解释 95% 或 99% 方差的主成分维度。通过查看累计方差解释率,你可以判断需要多少个主成分来保留足够的信息。例如:

- 如果前 5 个主成分能解释 95% 的方差,那么可以将维度降到 5 维。

- 如果需要保留更多信息,则可能选择能解释 99% 方差的主成分,维度可能会更多。

肘部法则(Elbow Method)

- 肘部法则可以用于确定最佳降维数。在绘制主成分的累积方差图时,找到一个“肘点”——即方差解释率开始趋于平缓的位置,作为降维后的维数。

- 这个肘点通常是保留信息量和减少维度之间的平衡点。

任务需求

- 如果你需要将数据降到 2D 或 3D 进行可视化,那么你可以直接将维度降到 2 维或 3 维。

- 对于某些任务来说,降到比输入维度略低的维度也可能会提高模型性能,因为减少了冗余信息和噪声。例如,原始数据有 100 个特征,你可能将其降到 20~30 个维度。

模型性能

- 通过降维后,训练一个模型并评估它的性能。

- 通常会实验不同的维度,找到一个能够在性能和效率上取得平衡的维度。

- 如果降维过多,可能会损失信息,导致模型表现下降;

- 如果降维不够,数据中的噪声和冗余信息可能依然存在。

经验法则

- 如果没有明确的指导原则或降维目标,经验上可以保留原始维度的 10%~20% 作为降维后的目标。

- 例如,100 个特征可以降到 10~20 维,然后在此基础上评估模型性能。

总结:

- 方差解释率 和 任务需求 是决定降维到几维的关键。

- 尝试保留能解释 95% 左右数据方差的主成分通常是一个好的起点。

机器学习chatgpt指令

- 写一个机器学习代码,主要包括以下流程,数据集是,3列输入,1列输出,80%作为训练集,20%作为测试集,采用k-fold交叉验证,采用SVR模型,并进行超参数优化,建立预测模型,然后评估R^2、残差和RMSE

Gene Expression Programming (GEP)

GPT-4o

即基因表达式编程,是一种基于遗传算法的进化计算技术,属于进化算法家族。

它是由 Cândida Ferreira 于 2001 年提出的,GEP 是遗传编程(Genetic Programming, GP)的扩展和改进。

它通过对表达式树进行编码和演化,来自动生成计算机程序或模型,以解决特定问题。

GEP 通过模仿生物基因表达过程来求解问题,主要思想是将计算机程序编码为线性染色体(类似基因),然后通过生物演化机制(选择、变异、交叉等)来演化解决方案。

基因型和表现型的分离:在 GEP 中,基因型(genotype)指的是线性染色体,这些染色体通过一定的编码规则表达为表现型(phenotype),即程序表达式或树结构。染色体通过进化机制进行变化,而表现型则是用来评估和计算解的结构。

线性染色体:GEP 使用线性字符串表示基因信息,这与遗传编程中的树结构不同。每个染色体由函数符号和操作符号组成,像基因一样进行变异、交叉等遗传操作。

表达式树(Expression Tree, ET):线性染色体经过解析后形成表达式树,这些树可以表示数学表达式、逻辑规则或程序结构。

Gene Expression Programming (GEP) 是一种结合了遗传算法和遗传编程优势的进化算法,具有较高的灵活性和效率。通过编码基因型并将其转化为表现型,GEP 能够自动生成复杂的数学表达式或程序模型,广泛应用于数据建模、优化和分类问题。

神经网络(Neural Networks)类型:

GPT-4o

- 前馈神经网络(Feedforward Neural Networks, FNN):信息只在网络中前向传递,不存在反馈。

- MLP 是最基础的前馈神经网络,它是全连接层的典型例子,网络中的每个神经元与下一层中的每个神经元相连。

- MLP 是最早的神经网络模型之一,通常用于分类、回归等任务。

- MLP 通常只能用于处理固定维度的结构化数据(如表格数据),而其他类型的神经网络(如 CNN、RNN)则擅长处理图像、时间序列、文本等不同类型的数据。

- MLP 可以是浅层的(只有一个隐藏层),也可以是深层的(多个隐藏层),当隐藏层很多时,MLP 就成为了深度神经网络(Deep Neural Networks, DNN)。

- 循环神经网络(Recurrent Neural Networks, RNN):允许网络中的节点与过去的状态进行反馈,用于处理时间序列数据。

- 卷积神经网络(Convolutional Neural Networks, CNN):专门处理图像数据,通过卷积层和池化层提取特征。

- 生成对抗网络(Generative Adversarial Networks, GAN):由生成器和判别器组成,主要用于生成数据。

神经网络 是一个广泛的概念,涵盖了不同类型的网络结构。

MLP 是前馈神经网络的具体实现形式之一,属于神经网络的子集。

MLP 是一种全连接神经网络模型,擅长处理结构化数据,是机器学习中最常用的基础神经网络模型之一。

2024-8月

Bernal-Fowler Rule

GPT-4o

Bernal-Fowler规则是用来描述水分子在冰中的氢键排列的一条规则。它由科学家John Desmond Bernal和Ralph H. Fowler在1933年提出,用于解释冰的结构。

Bernal-Fowler规则的核心内容包括以下几点:

- 每个氧原子周围有四个氢键:在冰的结构中,每个氧原子周围会形成四个氢键,与邻近的四个水分子相连。

- 两根氢键指向氧原子:在这四个氢键中,两个氢键中的氢原子靠近氧原子(即O-H键是短的),而另外两个氢键的氢原子远离氧原子(即H原子在另一个水分子的邻近位置)。

- 每个水分子的氢键分布满足规则:每个水分子中,两个氢原子形成氢键指向相邻的氧原子,两个氢键则来自于相邻的水分子的氢原子。

固体表面能够促进水合物分解?

- As expected, the higher the temperature, the faster the decomposition rate. Compared with the hydrate decomposition in the free system, the solid surface can enhance hydrate decomposition; the hydroxylated silica surface has better enhancement effect, and this effect is more obvious at lower temperatures.

- https://doi.org/10.1016/j.molliq.2023.122129

逸度差(fugacity difference)

chatgpt-3.5

逸度差指的是在系统中两个状态或相之间的逸度差异。

逸度是一个热力学性质,用于描述物质从一个相中逸出的倾向,常用于化学工程和热力学中。

术语解释

逸度(f):

逸度是描述物质在给定相中逃逸倾向的量,类似于“有效压力”。它考虑了相对理想行为的偏差。( f_e ):

通常表示物质在某一特定状态或相中的逸度,比如在平衡状态下的逸度。( f ):

表示物质在另一状态或相中的逸度。

逸度差的应用

逸度差 ( f_e - f ) 用于理解物质在不同条件或相之间逸度的变化。这在以下方面非常有用:

- 相平衡计算:在相平衡情况下,平衡时各相中物质的逸度应该是相等的。

- 化学反应平衡:帮助确定反应的平衡条件。

- 相变分析:帮助理解相变的程度或影响。

通过计算逸度差,可以得到有关系统状态和相互作用的重要信息。

初始水含量对水合物分解的印象

- 自保存self-preservation被认为是天然气水合物运输和储存的有利特性。然而,它也可能给钻井和水合物开采带来严重的麻烦。

- 多孔沉积物的存在并不影响甲烷水合物异常自保存区域。

- 甲烷水合物解离速率随初始水含量和石英砂整体粒径的降低而增大。

- 然而,在非常低的初始水含量(10 vol%)和小颗粒沉积物(25–38 μm)条件下仍然可以观察到自保存。

- https://doi.org/10.1016/j.apenergy.2020.115008

水合物饱和度高和低谁最容易受到水侵?

- 水合物饱和度高的位置受水侵影响较弱,而水合物饱和度低的位置更容易受到影响;

- https://doi.org/10.1016/j.energy.2021.121183

大孔中水合物更易于分解?写错了,还是真的?

- Previous studies showed that gas hydrates dissociated more easily in sediment with high porosity and large pore size.

- 没有其他参考文献,只是作者陈述,与其他文献中不同

- The dissociation process of gas hydrates in larger size sediments had higher heat and mass transfer efficiency and higher decomposition rate.

- https://doi.org/10.1016/j.apenergy.2023.121694

孔隙尺寸对水合物分解有很大影响

- https://doi.org/10.1021/jp012823w

- 测量了孔径为4至100纳米的孔隙中天然气水合物的分解压力和温度,以确定控制孔隙效应的参数。在给定压力下,分解温度随孔径减小而降低,符合Gibbs-Thomson方程

气泡密度过大可能会抑制水合物分解?

液体中直径较小的微泡密度大,阻碍了压力传递和热量传递,这是抑制水合物解离速率的关键。

2024-7月

压裂技术在水合物开采过程中的应用

- 压裂技术是在天然气水合物沉积物中增加孔隙度、连通人工裂缝和天然裂缝,形成相互连通的裂缝网络,从而提高天然气水合物沉积物导流能力的主要机械解决方案。

岩石多孔介质对水合物的作用

- 岩石的热导率高于水合物

- 水合物生成是一个放热过程,高的热导率使得传热迅速,水合物能快速生成;

- 水合物分解是一个吸热过程,高导热的岩石会快速传热,水合物会二次生成。

水合物在砂岩中是最常见的

Fuel 369 (2024) 131727

- Hydrates can be found in a variety of rocks, including clay, zeolites, and silicates, but sand is the most common.

表面活性剂是一个好的水合物形成促进剂,但会生成泡沫

Fuel 369 (2024) 131727

Surfactants (surfactants) are considered good kinetic promoters, but they have the significant disadvantage of abundant foaming, which interferes with gas recovery

and can lead to equipment plugging.氨基酸和它的衍生物对于无泡沫促进剂是有潜力的。

动力学促进剂目前还没有一个公认作用机理

Fuel 369 (2024) 131727

- There is still no single recognized mechanism of action of kinetic promoters, there are a number of assumptions of varying degrees of evidence

self-preservation effect of hydrates

Chem. Eng. J. 2022;435:134917.

- the self-preservation effect allows hydrates to be stored at atmospheric

pressure and temperatures slightly below zero

random process of hydrate formation

Appl. Therm. Eng. 2017;118:630–7.

- The formation of gas hydrates is a stochastic process and is limited by

mass and heat transfer